7月1日,,項目負責人褚明(中)指導團隊核心成員開展相關實驗。河北日報記者周聰聰攝

閱讀提示

在人機協同作業(yè)日益普及的今天,工人在生產線上與機器人“并肩作戰(zhàn)”時,,真的足夠安全嗎?如果答案并不似我們想象中樂觀,,如何在人機共存的環(huán)境中確保人的安全,?

不久前,第二屆雄安未來之城場景匯雄安國際機器人大賽上,,參賽項目“數字孿生驅動的人機協作安全距離快速感知系統”為這個難題給出了創(chuàng)新解決方案,。

48毫秒的超快響應速度、無需外掛設備就能實現360度無死角安全防護,、低至2萬元的部署成本……憑借這些突破性優(yōu)勢,,該項目成功斬獲大賽一等獎,重新定義著工業(yè)場景下人機協作的安全標準,。

6月12日,,第二屆雄安未來之城場景匯雄安國際機器人大賽上,參賽項目“數字孿生驅動的人機協作安全距離快速感知系統”現場演示,。褚明供圖

超快反應,,讓人與機器人安全協作

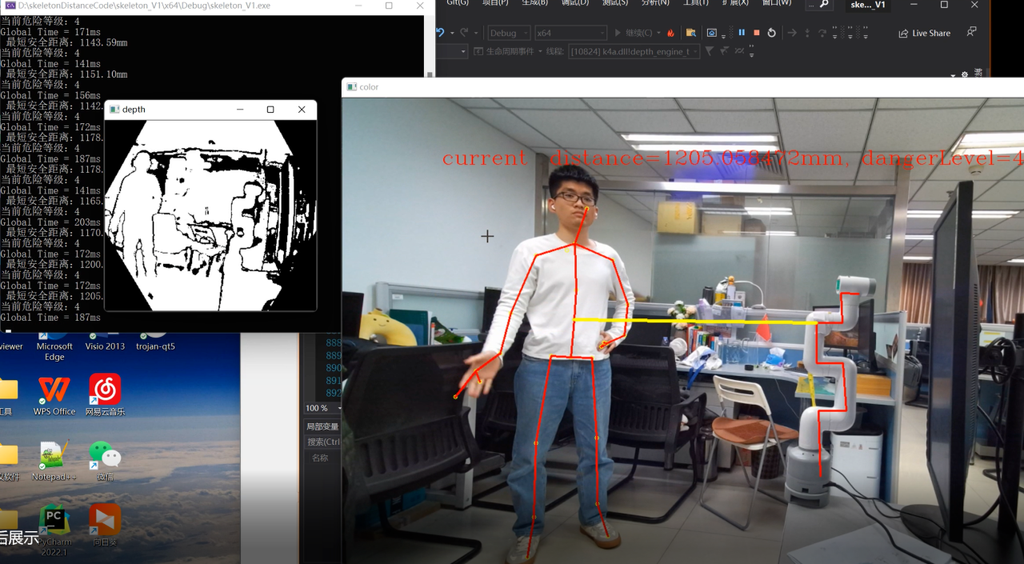

六軸桌面式協同機械臂輕盈舞動關節(jié),但當人靠近,,一旁的電腦屏幕上立刻浮現數道醒目的紅色線條,,勾勒出人體的骨骼結構。同時,,一道在人與機械臂之間動態(tài)生成的明黃色線條實時測量二者距離,,并據此給機器人下達“停機”“減速”等指令,將有可能對人造成的安全傷害扼殺在萌芽中……

6月20日,,北京郵電大學科研樓924室,,“數字孿生驅動的人機協作安全距離快速感知系統”展示著毫秒級的危險預警能力。

在第二屆雄安未來之城場景匯雄安國際機器人大賽上,,該項目憑借出色的實時感知性能和人機交互安全性,,從眾多參賽項目中脫穎而出,榮膺大賽一等獎,。

人機協作的安全距離,,是這項研究的核心問題。

或許有人會疑惑,,機器人不都是按照預設程序精準作業(yè)的嗎,?為何還需要專門研究人和機器人的安全距離,?

“人們把機器人稱為‘人’,這種說法其實高估了它的智能水平,。”項目負責人,、北京郵電大學智能工程與自動化學院教授褚明解釋,機器人確實能高效完成重復性,、高強度的任務,,但它的智能遠未達到與人類真正協同共處的程度。在早期工業(yè)應用中,,機器人作業(yè)時甚至需要被鐵絲網隔離,,以確保人員安全。

如今,,隨著技術的突破性發(fā)展,,機器人總動員正成為智能制造新常態(tài)。

“然而,,在人機共存的生產環(huán)境中,,安全防護體系仍面臨嚴峻挑戰(zhàn),工業(yè)機器人事故時有發(fā)生,。”褚明介紹,,其中機器人制造和焊接是事故高發(fā)領域。

“當前工業(yè)領域的人機安全監(jiān)測主要依賴激光雷達,、紅外和聲波測距等技術,,但都存在明顯缺陷。”褚明分析,,這類設備幾乎全要外掛在機器人上,,以激光雷達為例,它形似礦泉水瓶,,直徑約10厘米,。機械臂掛上這樣一個瓶子,不僅影響工作的靈活性,,甚至還會帶來新的安全隱患,。

除了體積問題,各類技術還有各種局限:聲波測距只能測量到正面相對的區(qū)域,,存在監(jiān)測盲區(qū),;激光雷達雖能全向覆蓋,但響應速度慢且成本高昂,,單臺價格超6萬元,。

鑒于硬件方案存在的成本高、干擾作業(yè)等現實問題,,多數企業(yè)選擇依賴管理規(guī)范等軟性防護,。但在實際生產中,,工人錯誤的操作習慣和企業(yè)投入不足的雙重因素,又導致事故頻發(fā),。

能否讓機器人輕裝上陣,,在不依賴外掛設備的情況下,就能實現360度全場景的安全監(jiān)測,?

2021年,,褚明研究團隊的這一構想,引起了西門子的興趣,。

基于和北京郵電大學既有的校企聯合技術攻關基礎,,西門子決定投入專項研發(fā)資金啟動聯合攻關。

面對傳統硬件方案“笨重昂貴”與“防護滯后”的雙重困境,,褚明帶領團隊另辟蹊徑,將數字孿生技術與計算機視覺深度融合,。不僅能使輕裝上陣的機器人擁有安全直覺,,還賦予其比人類更快的反應能力。

“人類在保持清醒的前提下,,發(fā)現危險并作出反應的平均時間是120毫秒,。”褚明一臉自豪地表示,但這套系統僅需48毫秒就能完成安全距離感知,,響應速度是人類的2.5倍,。

褚明說,這套系統不僅反應快,,還能“一心六用”,,同時追蹤6個作業(yè)人員的人機距離,確保每個人都能獲得同樣迅捷的防護響應,。

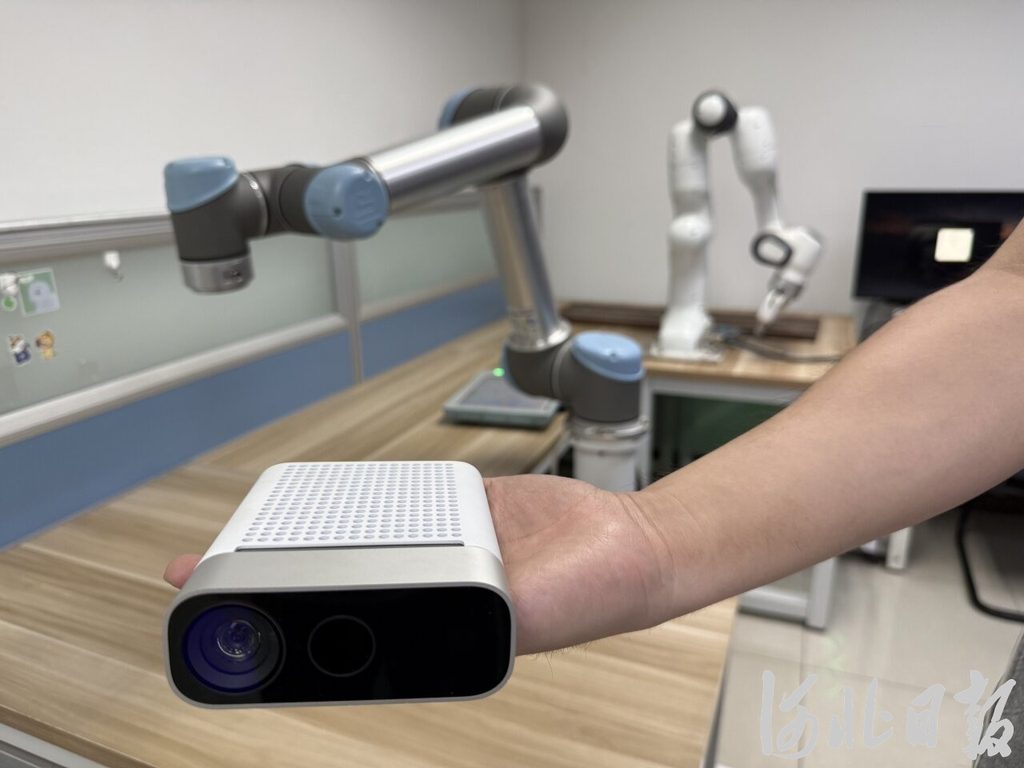

7月1日拍攝的參賽項目所用深度相機,,它能讓機器人在“零穿戴”的情況下擁有360度全場景視角。河北日報記者周聰聰攝

給機器人裝上“天眼”,,360度無死角安全防護

“讓機器人擁有安全直覺,,傳統方案是給它‘穿盔戴甲’,我們的辦法則是‘開天眼’,。”拿起一個紙抽大小的白色深度相機,,褚明輕輕晃了晃說,這是整套系統中唯一的硬件設備,,卻能讓機器人在“零穿戴”的情況下擁有360度全場景視角,。

這臺深度相機性能強大,每秒能拍攝60幀畫面,,相當于每16.67毫秒就能完成一次對人的動態(tài)捕捉,。

研究團隊巧妙利用這一特性,,構建了一個實時運轉的數字孿生世界:相機采集的人體骨骼數據和機械臂運動軌跡,在虛擬空間中同步生成動態(tài)模型,,通過算法實時計算碰撞風險,,實現從感知到防護的無縫銜接。

數據采集,、孿生建模,、風險計算……這一系列復雜運算,如何在遠低于人類反應速度的48毫秒內完成,?

指著電腦屏幕上那些與人體動作神同步的紅色線條,,褚明道破秘訣所在。

“現實中我們看到的是人和機器人的互動,,但在數據世界里,,我們構建的卻是極簡主義的骷髏級交互模型。”褚明解釋,,深度相機通過識別人體32個骨骼關鍵點,,實時構建動態(tài)骨骼框架,實現精準動作捕捉,。在此基礎上,,團隊進一步篩選出其中25個關鍵點,包括手指尖,、腳尖等人體最遠端,,以及肩、肘,、髖等主要活動關節(jié),。

“篩減時,我們舍棄了面部等非必要區(qū)域的關鍵點,,保留下來的都是能影響人體可能觸及最大空間范圍的關鍵點,。”褚明說。

有了人體的動態(tài)模型,,團隊利用工業(yè)機器人內置的光電碼盤傳感器,,實時獲取各個軸關節(jié)角度數據,僅用9個關鍵點即可完整重構機器人運動姿態(tài),。

就這樣,,僅僅靠34個關鍵點,團隊便完成了人和機器人的建模,。這種高度簡化的建模方式,,大大降低了系統數據計算量,有效提升了數字孿生場景的構建效率,為毫秒級實時響應提供了關鍵技術保障,。

不過,,要實現真正可靠的人機安全協同,挑戰(zhàn)遠未結束,。

采訪中,,記者曾變換各種動作和距離,屢屢試圖“碰瓷”機器人,。但遺憾的是,,一次都沒成功。電腦屏幕上,,一條黃線始終如影隨形地橫亙在記者和機器人之間,,并不斷變換著距離數據。隨著距離數據的變化,,機械臂或轉速下降,,或瞬間停止,始終與記者保持著安全距離,。

“這根黃線,,標注的是人和機器人間的最短距離。”褚明說,,系統正是根據這個距離數據,設置了低危,、中危,、高危三級安全閾值,向機器人做出聲光預警,、減速運行,、緊急停機等指令。

為找到這條黃線,,去年畢業(yè)的博士生,、團隊核心成員陳宇足足花了一年多時間。

“兩個‘骨架’關鍵點間連成的線成千上萬條,,這其中,,哪條才是最短的?”陳宇解釋,,不同于靜態(tài)物體,,人和機械臂始終處于運動狀態(tài)。特別是人體動作具有天然的隨機性和不可預測性,,兩者的運動軌跡在三維空間中不斷交織,,形成高度復雜的動態(tài)空間關系。

為了更真實地計算人體與機器人的安全距離,研究團隊還考慮到人的胖瘦對二者距離的影響,,根據成年人的體型中位數,,在骨骼模型基礎上做了一層“膠囊體”,為數字模型穿上了一層“肌肉外衣”,。

“多次試驗驗證,,系統的距離測量誤差已經被嚴格控制在3.5%以內,相當于當實際距離為1米時,,系統測量值在96.5至103.5厘米之間波動,。”褚明說,這個精度窗口是經過反復推敲后確定的最佳平衡點,,既能夠規(guī)避過度追求精度帶來的算力浪費,,又確保了工業(yè)場景下的絕對安全。

當人靠近六軸桌面式協同機械臂,,電腦屏幕上立刻浮現數道紅色線條勾勒出人體的骨骼結構,。同時,在人與機械臂之間動態(tài)生成一條明黃色線條實時測量二者距離,。圖為實驗過程中拍攝的電腦屏幕顯示畫面,。褚明供圖

成本低、部署快,,產業(yè)化優(yōu)勢突出

“安裝復雜嗎,?成本會不會很高?”在第二屆雄安未來之城場景匯雄安國際機器人大賽上,,“數字孿生驅動的人機協作安全距離快速感知系統”使用的便捷性和經濟性,,成為許多參觀者駐足咨詢的熱點。

對此,,褚明的回答令他們眼前一亮,。

“這套系統的部署極其簡單,就像在工廠安裝普通監(jiān)控攝像頭一樣便捷,。”褚明說,,系統的運行,僅依賴深度相機和軟件模組,,每個定焦深度相機可精準覆蓋6米遠范圍,,單個6米遠監(jiān)控區(qū)域的部署成本僅2萬元。

更令人驚喜的是,,如果監(jiān)測范圍需要擴大,,只需線性增加攝像頭數量,無需額外復雜配置,,大幅降低了整體投入,。

兼容性強,、成本低、部署快,,該系統的種種優(yōu)勢,,讓不少制造企業(yè)當場就表達了合作意向。

一家焊接機器人企業(yè)負責人向褚明坦言,,他們正面臨嚴峻的人機協作安全挑戰(zhàn):在自動化焊接產線上,,雖然核心焊接工序由機械臂完成,但上下料環(huán)節(jié)仍需人工介入,。工人頻繁進出作業(yè)區(qū)域時,,既要防范機械臂的意外碰撞,又要躲避飛濺的高溫焊渣,,安全風險居高不下,。

“對我們這樣的焊接企業(yè)來說,這套系統絕對是剛需,。”這位企業(yè)負責人還對該系統產業(yè)化提出建議,,除獨立銷售外,還可以與機械臂捆綁銷售作為機械臂的增值服務,,提升產品競爭力,。

企業(yè)之外,滄州市招商部門也向褚明詳細介紹了各種產業(yè)化扶持政策,,表達了助力這項技術快速落地的強烈意愿,。

“這是我們第一次參加雄安場景匯,目的就是讓這項技術接受市場的真實檢驗,,看它是否能切實解決企業(yè)的安全生產痛點,。”褚明說,他們希望通過這種方式,,持續(xù)優(yōu)化技術方案,推動實驗室成果走出象牙塔,,真正服務實體經濟,。

在推動項目落地產業(yè)化的同時,團隊在人機共存領域的研究仍在持續(xù)深化,。

“目前,,我們正在研究從仿真到實體的相關課題,推動人機協作向更高層級發(fā)展,。”褚明介紹,,他們的研究大方向是讓機器人不僅能感知人的存在,更能理解人的意圖,,推動人機共存走向人機共融,。

“工業(yè)4.0實現了生產數字化,但其本質仍是機器主導的生產模式,人只是被動地嵌入其中,。而正在興起的工業(yè)5.0則強調人機融合,,在共同的工作環(huán)境中開展更精密、更智能的協作,。”褚明解釋,。

未來的人機協作會是怎樣一幅新圖景?

“以電路板精密裝配為例,,目前這類精密裝配仍需工人完成30多道工序,,頻繁切換十余種工具來取放微小元器件,不僅勞動強度大,,效率也不高,。”褚明說,理想的人機協作應該是,,當工人伸手準備焊接時,,機械臂能智能識別這一意圖,主動遞送焊槍,;當需要安裝微型電容時,,又能精準奉上對應元件。這樣的場景下,,機器人就像個得力的智能助手,,始終默契配合,和人達到心有靈犀的協作水平,。

“而這,,正是我們努力研究的方向。”褚明相信,,這一天的到來不會太遠,。(河北日報記者 周聰聰)

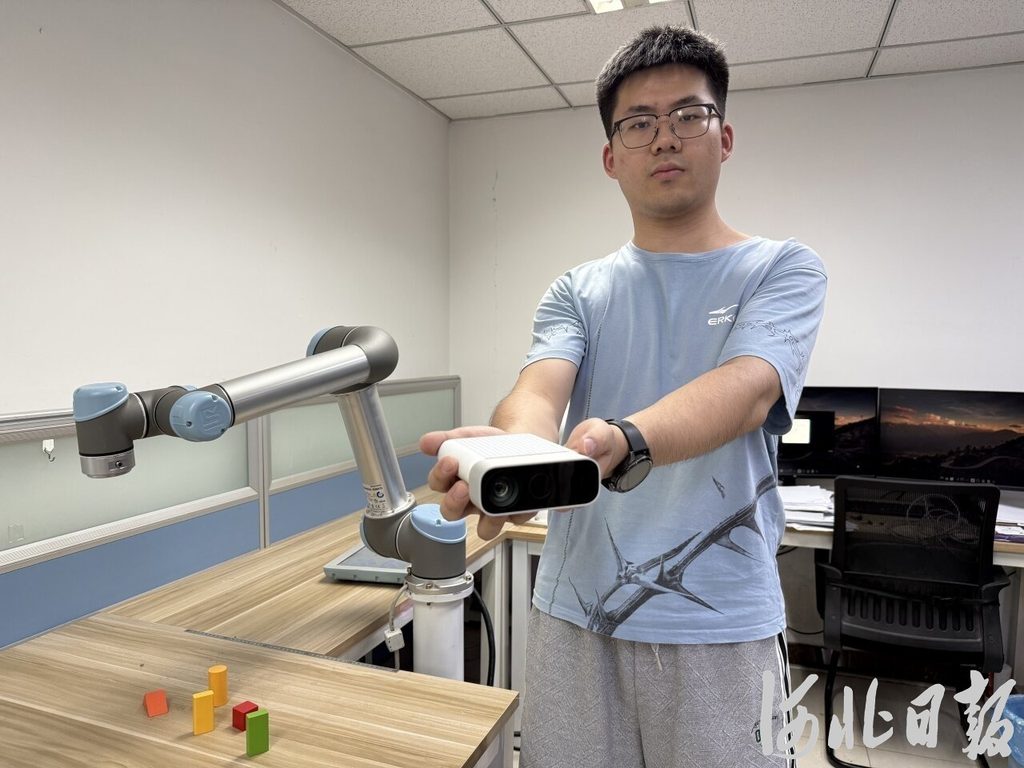

7月1日,團隊核心成員展示參賽項目所用的深度相機,,它能讓機器人在“零穿戴”的情況下擁有360度全場景視角,。河北日報記者周聰聰攝

記者感言

極簡背后的極繁探索

一個深度相機,一個軟件模塊,,靠著這樣的簡單組合,,“數字孿生驅動的人機協作安全距離快速感知系統”實現了48毫秒的極速感知,將人機協作中的潛在安全風險扼殺在萌芽狀態(tài),。

極簡實體,、極速感知、極度安全,,項目負責人褚明用三個“極”來概括這項成果的特點,。

但成果有多“簡”,,過程就有多“繁”。

采訪中,,褚明一開始并沒有急于展示成果,,而是先回顧了一段失敗的經歷。這個坦誠的開場,,讓記者了解了科研工作的真實軌跡,。

最初,團隊選擇的技術路徑頗具吸引力,,模擬人類雙眼的立體視覺測距原理,,計算深度相機發(fā)射的調制光線的往返時間差,來構建人體三維輪廓,。

這種仿生學思路看似完美,,卻在實踐中遭遇瓶頸。為了找到最近距離點,,系統需要把遍布人體表面的所有關鍵點計算一遍,,龐大的計算量導致建模延遲,遠達不到工業(yè)安全防護響應的時效要求,。

就這樣,,研究一度陷入困境。

在失敗中尋找希望,,團隊再次調整思路,,利用深度相機自帶的關鍵點捕捉功能,通過精心篩選25個人體關鍵點和9個機械臂節(jié)點,,將原本復雜的建模過程簡化,。思路的轉變,讓數字孿生建模效率得到質的飛躍,。

讓機器人實現智能,,每一步都不容易。

為了找到合適的深度相機,,團隊核心成員張萌花了三個多月,,對比了三十多款產品的詳細數據。為了獲取更多詳細數據,,她不得不一家家聯系廠商,有時甚至要跨時區(qū)與國外廠家反復溝通,。

“有多少人工,,才有多少智能。”采訪中,,褚明反復提及的這句話,,道破了人工智能研究的真諦,。

而創(chuàng)新的魅力,恰恰藏在這份“極簡”與“極繁”的辯證之中,。

在采訪尾聲,,褚明特別提到德國工業(yè)5.0倡導的人機共融愿景。那時候,,機器人不再是冰冷的執(zhí)行者,,而是能理解意圖、預判需求的智能伙伴,。

這種充滿溫度的技術想象,,讓我們有理由相信,當極簡的智能與極繁的探索持續(xù)碰撞,,科技創(chuàng)新的未來必將綻放更多可能,。

文/河北日報記者 周聰聰